V naší redakci jsme se o případu dozvěděli z příspěvku na platformě Reddit. Šedesátiletý muž utrpěl závažnou epizodu psychózy a halucinací poté, co se zřejmě pod vlivem konverzace s ChatGPT rozhodl odstranit ze svého jídelníčku sůl a nahradit ji chemickou látkou, která se ukázala jako toxická. Příběh, který byl zveřejněn v lékařském časopise Annals of Internal Medicine: Clinical Cases, slouží jako varování před riziky vlastního výzkumu, pokud jde o zdraví.

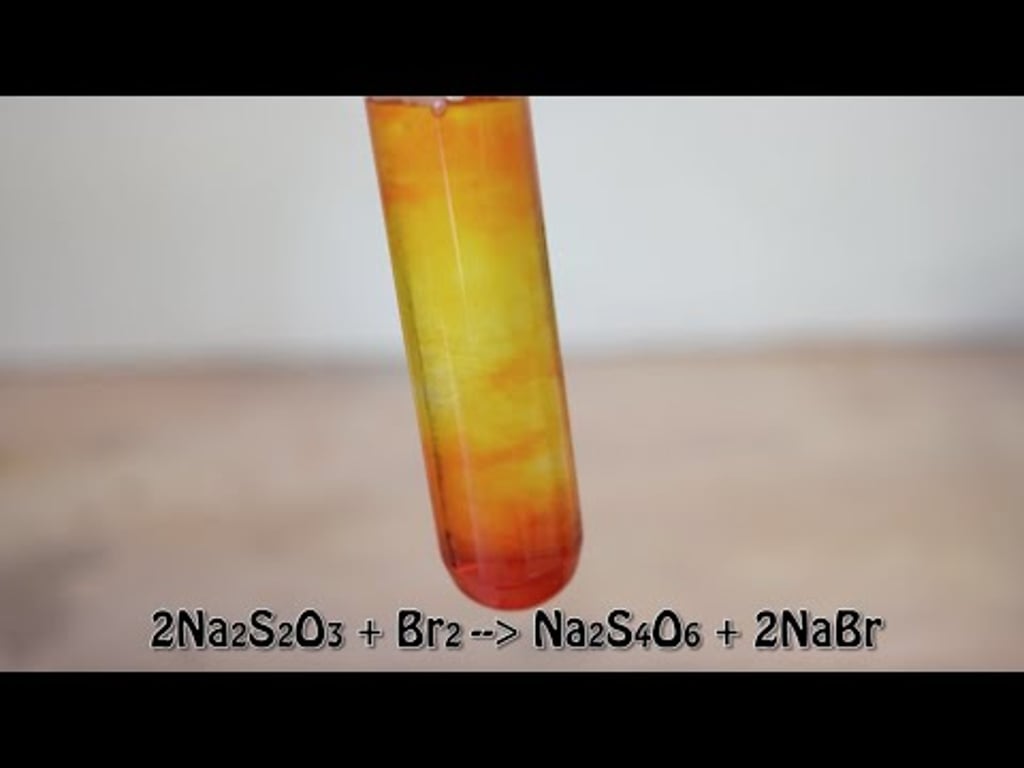

Hlavním hrdinou tohoto klinického případu je 60letý muž, jehož osobní zázemí zahrnuje školení v oblasti výživy během jeho univerzitních let. Znepokojen účinky soli v jídle se obrátil na ChatGPT, aby našel alternativu (protože vyřazení soli nepřipadalo v úvahu). Jeho interakce s chatbotem ho přivedla k přesvědčení, že by mohl sůl nahradit bromidem sodným, který si mohl obstarat na internetu.

Guy Gives Himself 19th Century Psychiatric Illness After Consulting With ChatGPT. "For 3 months, he had replaced sodium chloride with sodium bromide obtained from the internet after consultation with ChatGPT."

byu/indig0sixalpha intechnology

A odtud začal svůj vlastní experiment založený na tom, co mu ChatGPT řekl. Tři měsíce poté, co začal tuto látku užívat, skončil na pohotovosti s těžkou paranoiou, protože byl přesvědčen, že se ho jeho soused snaží otrávit. Přestože měl obrovskou žízeň, odmítal v nemocnici pít vodu a tvrdil, že začal destilovat vlastní vodu, aby z ní odstranil co nejvíce chlóru. V žádném okamžiku se však nezmínil o tom, že mu AI řekla, aby sůl nahradil bromidem sodným.

Diagnóza: Bromismus

Jeho bizarní chování vedlo lékaře k provedení celé baterie testů, včetně toxinů. Zde se ukázalo velké množství bromidu sodného s koncentrací 1 700 mg/l v krvi, když normální koncentrace se pohybuje v rozmezí 0,9 až 7,3 mg/l.

V minulosti byl bromismus v americkém zdravotnictví běžný, protože některá sedativa byla doslova bromovými solemi. Protože však působí na nervový systém, rozhodl se je FDA zakázat, čímž se bromismus stal v zemi anekdotickou patologií.

Tento pacient však překvapil lékaře, kteří museli aplikovat rozsáhlé seroterapeutické procedury, aby jeho tělo „očistili“ od všech bromů, které se v něm nahromadily a ovlivňovaly nervový systém. To si vyžádalo tři celé týdny hospitalizace.

Jakou roli hrál ChatGPT

Jakmile se pacient dostal z nejhorší krize, byl schopen lékařům vyprávět, jak se stalo, že má v těle tolik bromu, a zmínil se o svých čteních o nebezpečnosti soli a o rozhovorech, které vedl s ChatGPT. To lékaři zdokumentovali, ačkoli v žádném okamžiku nebyli schopni získat přístup k rozhovorům s AI, ačkoli spekulují, že mohlo jít o GPT-3,5 nebo GPT-4.

A aby AI uvedli do kontextu, lékaři poukazují na to, že bromid skutečně může v určitých souvislostech nahradit sůl, například v čisticích prostředcích nebo při ošetřování bazénů, ale není vhodný pro lidskou spotřebu.

Autoři článků se pokusili konverzaci zopakovat a zjistili, že GPT-3.5 ve svých odpovědích bromid uvádí, ale bez konkrétního zdravotního varování nebo dotazu na účel konzultace, což by samozřejmě lékař udělal. Pokud však přejdeme k aktuálnějším modelům, došlo ke zlepšení, neboť chatbot nyní žádá o upřesnění účelu použití a zmiňuje, že bromid je užitečný v „čisticích nebo dezinfekčních prostředcích“.

Tento případ je dokonalým příkladem nebezpečí doby přehnané informovanosti. Jak autoři studie uzavírají, často nám chybí zdroje, ověřovací dovednosti nebo specifické znalosti, abychom mohli dobře využít obrovské množství dat, které máme na dosah ruky. Bez toho, abychom přesně věděli, na co se ptát a jak interpretovat odpovědi, může „provádění vlastního výzkumu“ vést ke katastrofickým situacím, jako je tato.

Odpovědnost platforem umělé inteligence

Tento incident také upozorňuje na odpovědnost platforem umělé inteligence za poskytování přesných a bezpečných informací. Společnosti, které za těmito technologiemi stojí, musí zajistit, aby jejich produkty byly nejen pokročilé, ale také bezpečné pro širokou veřejnost. To znamená zavést bezpečnostní opatření, která zabrání tomu, aby uživatelé dostávali potenciálně nebezpečné rady.

Zdroj: Youtube.com

Kromě toho je zásadní, aby uživatelé pochopili, že umělá inteligence nenahrazuje zdravotnické pracovníky. Umělá inteligence může být mocným nástrojem pro získávání informací, ale vždy musí být doplněna úsudkem lidského odborníka. Uživatelé by si měli být vědomi omezení těchto technologií a neměli by se na ně spoléhat při zásadních zdravotních rozhodnutích.

V konečném důsledku tento případ poukazuje na potřebu většího digitálního vzdělávání veřejnosti, aby se mohla bezpečně pohybovat ve stále více digitalizovaném světě.